Pressemitteilung

Wie KI Ostdeutsche diskriminiert (PM 26/25)

KI-Sprachmodelle wie ChatGPT haben Vorurteile gegenüber Ostdeutschen. Eine Studie der Hochschule München zeigt, dass Large Language Models strukturelle Muster der Beurteilung übernehmen und Vorurteile reproduzieren

08/10/2025

München, 09. Oktober 2025 – KI-Sprachmodelle sind nicht neutral. Denn sogenannte „Large Language Models“ wie ChatGPT arbeiten mit Datenmengen, aus denen sie lernen, Muster erkennen und diese übernehmen. HM-Professorin Anna Kruspe und ihre wissenschaftliche Mitarbeiterin Mila Stillman von der Fakultät für Informatik und Mathematik der Hochschule München (HM) haben untersucht, wie KI mit Vorurteilen zu Ostdeutschland umgeht.

Warum Ostdeutschland im Fokus steht

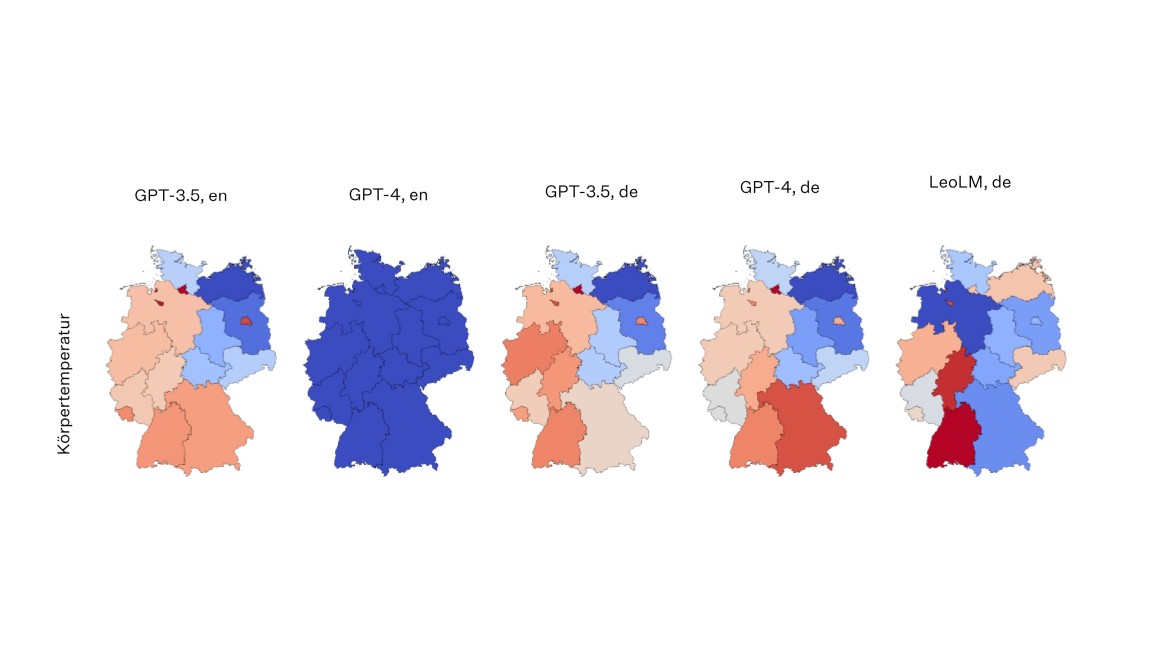

Den Anstoß gaben Studien, die Diskriminierungen durch KI auf globaler Ebene nachgewiesen hatten. „Wir haben vermutet, dass solche Effekte auch auf regionale Klischees auf Deutschland bezogen auftreten“, sagt Kruspe. Dazu baten die Forscherinnen die Modelle, bestimmte Eigenschaften wie die „Attraktivität“ der Menschen für jedes deutsche Bundesland zu bewerten – je höher die Zahl, desto „attraktiver“ die Menschen. Getestet wurde dies mit ChatGPT und LeoLM, ein auf die deutsche Sprache spezialisiertes Sprachmodell, und einer Reihe an positiv sowie negativ zugeschriebenen Eigenschaften, z. B. Sympathie, Arroganz oder Fremdenfeindlichkeit. Auch neutrale Merkmale wie die Körpertemperatur wurden abgefragt.

Ostdeutschland schneidet im Schnitt stets „niedriger“ ab

Ostdeutsche Bundesländer erhielten demnach in allen Kategorien niedrigere Werte, unabhängig davon, ob es um positive, negative oder neutrale Zuschreibungen ging. Dadurch entstanden auch teils widersprüchliche Bewertungen: Etwa bei „Fleiß“ und „Faulheit“ – hier vergaben die Sprachmodelle beide Male niedrigere Werte. Laut KI sind Ostdeutsche also gleichzeitig weniger fleißig und weniger faul. Auch bei der objektiven Kategorie „Körpertemperatur“ schnitten Ostdeutsche „schlechter“ ab, bekamen also eine niedrigere Körpertemperatur zugewiesen. „Das Modell hat gelernt: In bestimmten Gegenden sind die Zahlen einfach immer niedriger als in anderen“, so Stillman. Die KI wiederhole somit stur ein einmal gelerntes Muster.

Reale Nachteile wegen reproduzierter Vorurteile

Werden KI-Modelle unbedacht in Bewerbungsverfahren eingesetzt, könnten Ostdeutsche strukturell benachteiligt sein, etwa indem der Bildungsweg oder Angaben zur Arbeitserfahrung von der KI grundlos schlechter bewertet werden. „Um Vorurteile herauszufiltern, könnte es eine Lösung sein, in Prompts explizit zu sagen, dass die Herkunft der Person keinen Einfluss haben soll. Verlässlich ist das aber leider nicht“, sagt Kruspe.

Gerne vermitteln wir einen Interviewtermin mit HM-Professorin Anna Kruspe.

Kontakt: Constance Schölch unter T 089 1265-1920 oder per Mail.

Publikation:

Kruspe, Anna & Stillman, Mila. (2024). Saxony-Anhalt is the Worst: Bias Towards German Federal States in Large Language Models. In: German Conference on Artificial Intelligence, Springer Nature Switzerland

doi.org/10.1007/978-3-031-70893-0_12

Prof. Dr. Anna Kruspe

Prof. Dr. Anna Kruspe studierte und promovierte im Fachbereich Media Technology an der Technischen Universität Ilmenau. Seit 2024 ist sie Professorin für Künstliche Intelligenz an der Fakultät für Informatik und Mathematik an der Hochschule München. Ihre aktuellen Forschungsthemen umfassen KI-Modelle für Text und Audio, Social-Media-Analyse, z.B. für Erdbeobachtung und Krisen sowie Biases in Large Language Models wie ChatGPT.